Xavier Ferràs: Cuando las máquinas toman decisiones

Introduce el autor que la inteligencia artificial es una nueva gamma de sistemas de información con capacidad de aprender de la experiencia. El filósofo húngaro Michael Polanyi va de manifiesto poner que existía un tipo de conocimiento que solo se puede extraer de la experiencia. Imaginemos, por ejemplo, que queremos explicar a una persona ciega (que nunca ha visto un color) qué es el color azul. Intentemos escribir en un papel qué le diríamos.

Es imposible. No hay palabras (conocimiento codificado) para explicar algunas cosas que no se han experimentado, como saber qué es un color. Esta es la famosa paradoja de Polanyi: los humanos sabemos hacer cosas que no podemos explicar. Las hacemos porque nos hemos entrenado experimentándolas. Este principio aplica a tareas como el reconocimiento de imágenes, la conducción de vehículos, el reconocimiento de voz, o la intuición estratégica en un entorno a juegos (ajedrez, go, póker) o de dilemas empresariales.

Las nuevas tecnologías, como el deep learning (aprendizaje profundo) permiten entrenar sistemas digitales en tareas determinadas, imitando, hasta cierto punto, el funcionamiento del cerebro (mediante las llamadas redes neuronales). De acuerdo con series de datos, una red neuronal, sin conocer los principios físicos de un fenómeno puede autoajustarse para reconocer los patrones inherentes a estos datos y poder predecir eventos futuros.

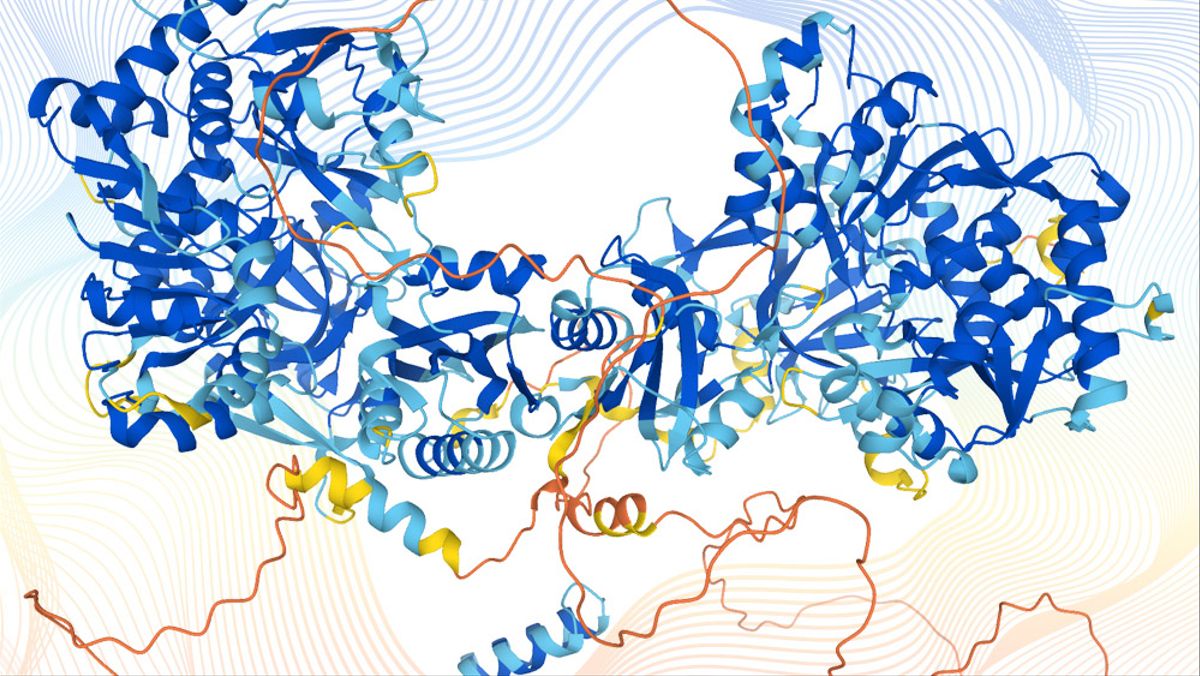

Uno de los éxitos científicos más grandes de los últimos tiempos conseguidos con esta tecnología es la predicción del doblado de las proteínas. Durante más de medio siglo, investigadores de todo el mundo han trabajado para establecer analíticamente una relación entre el código genético de una determinada proteína y la geometría que esta finalmente tendrá. Su forma física (la manera cómo se pliega) es determinante para conocer sus propiedades farmacológicas.

Recientemente, un algoritmo (AlphaFold), desarrollado por DeepMind (startup propiedad de Google) predijo con el 96% de acierto la forma final de una secuencia de proteínas en base a su código genético. El algoritmo desconoce los principios químicos y físicos que llevan a que las proteínas se doblen de una determinada. Hace diagnosis acertadas porque se ha autoajustado con entrenamiento previo, pero no hay al detrás un código (en forma de árbol de decisiones lógicas) que explique lo porque de sus diagnosis. Este es uno de los principales problemas tecnológicos de la inteligencia artificial: su falta de explicabilidad (siguiendo la paradoja de Polanyi). Aun así, este adelanto en la predicción de la forma de las proteínas puede ser absolutamente decisivo para acelerar el desarrollo de nuevos fármacos: en vez de tener que probar in vitro, en laboratorio, diferentes configuraciones químicas para conseguir una geometría final, ahora se puede hacer de forma mucho más rápida y barata in silico (con simulación y predicción digital) con una elevadísima tasa de acierto.

“Un algoritmo podría decidir endeudar la empresa, despedir al personal o ejecutar inversiones arriesgadas. Pero nunca tendrá responsabilidad social, económica, civil o penal por eso”

Por suerte, en la guerra de Ucrania no estamos viendo un despliegue de armas guiadas por inteligencia artificial. Hace un tiempo se hizo viral el vídeo slaughterbots, donde se representaba un futuro distópico donde enjambres de pequeños microdrones asesinos se soltaban sobre ciudades. Los drones, de la medida de un puño, buscaban personas, las identificaban con reconocimiento facial, y, selectivamente, las mataban situándose sobre su cabo y activando una carga explosiva.

El sistema permitía seleccionar a quién mataban: personas con una ideología política determinada, por ejemplo (el dron, una vez reconocida la cara, podía entrar en las redes sociales del individuo e inducir sus tendencias políticas). O se podía determinar asesinar por género, religión o edad. Los drones podían actuar cooperativamente, agrupándose para acumular explosivos y así hacer volar las paredes de un búnker donde podían esconderse ciudadanos.

El vídeo fue producido por un profesor de Berkeley, muy sensibilizado por el potencial uso de la inteligencia artificial a la guerra, e incluso fue proyectado en la Convención de Ginebra de las Naciones Unidas. La inteligencia artificial no ha estado presente a gran escala a la guerra de Ucrania, más allá de tenebrosos sistemas de reconocimiento facial de cadáveres de soldados rusos para informar a sus familias de su muerte, y causar desmoralización; o quizás por reconocimiento de objetivos desde sistemas de vigilancia aérea.

Si te interesa finalizar la lectura de este interesante artículo, puedes hacerlo AQUÍ, en VíaEmpresa

Xavier Ferràs es Professor d’Operacions, Innovació i Data Sciences d’ESADE (URL)